Paper:https://arxiv.org/pdf/2103.02907.pdf

GitHub:https://github.com/Andrew-Qibin/CoordAttention

轻量,优秀,好用!

小知识

我从论文中提取的只言片语。。。

标准卷积本身很难对信道关系建模。

显式地构建通道间的依赖关系可以增加模型对信息通道的敏感性,这些信息通道对最终分类决策的贡献更大。

使用全局平均池还可以帮助模型捕获卷积所缺少的全局信息。

讲之前我们先回顾一下以前的SE与CBAM

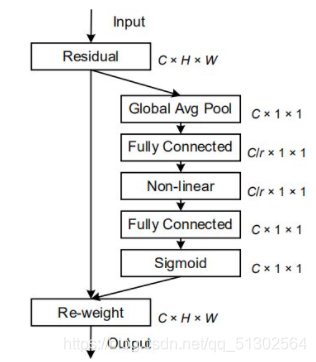

SE

SE比较简单,看一下结构图差不多就能理解了,如果有些实现不太懂的,可以借鉴一下CBAM的。

但SE只考虑内部通道信息而忽略了位置信息的重要性,而视觉中目标的空间结构是很重要的。

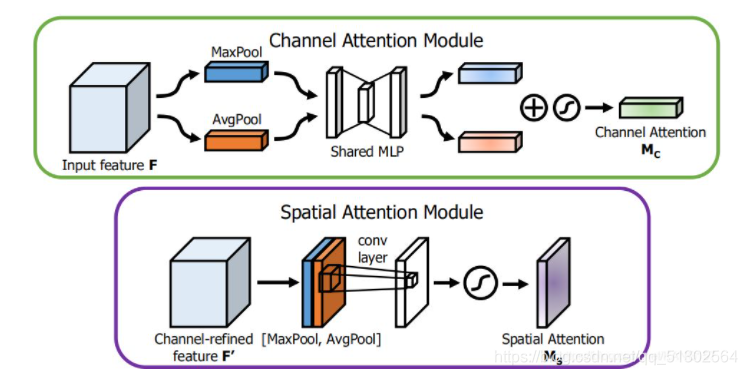

CBAM

稍微介绍一下CBAM,如图b所示,CBAM包含空间注意力和通道注意力两部分。

通道注意力:对input feature maps每个feature map做全局平均池化和全局最大池化,得到两个1d向量,再经过conv,ReLU,1x1conv,sigmoid进行归一化后对input feature maps加权。

空间注意力:对feature map的每个位置的所有通道上做最大池化和平均池化,得到两个feature map,再对这两个feature map进行7x7 Conv,再使BN和sigmoid归一化。

通道注意力机制

1 | class ChannelAttention(nn.Module): |

空间注意力机制

1 | class SpatialAttention(nn.Module): |

BAM和CBAM尝试去通过在通道上进行全局池化来引入位置信息,但这种方式只能捕获局部的信息,而无法获取长范围依赖的信息。(经过几层的卷积后feature maps的每个位置都包含了原图像一个局部区域的信息,CBAM是通过对每个位置的多个通道取最大值和平均值来作为加权系数,因此这种加权只考虑了局部范围的信息。)

Coordinate Attention

现在我们进入正题:

本文提出的协调注意块(c)与经典SE通道注意块(a)和CBAM注意块(b)的示意图(下图)比较。这里的“GAP”和“GMP”分别指全局平均池和全局最大池。“X平均池”和“Y平均池”分别指一维水平全局池和一维垂直全局池。

注意力机制用于移动网络(模型比较小)会明显落后于大网络。主要是因为大多数注意力机制带来的计算开销对于移动网络而言是无法承受的,例如self-attention。

因此,在移动网络上主要使用Squeeze-and-Excitation (SE),BAM和CBAM。但SE只考虑内部通道信息而忽略了位置信息的重要性,而视觉中目标的空间结构是很重要的。BAM和CBAM尝试去通过在通道上进行全局池化来引入位置信息,但这种方式只能捕获局部的信息,而无法获取长范围依赖的信息。

这里稍微解释一下,经过几层的卷积后feature maps的每个位置都包含了原图像一个局部区域的信息,CBAM是通过对每个位置的多个通道取最大值和平均值来作为加权系数,因此这种加权只考虑了局部范围的信息。

在本文中提出了一种新颖且高效的注意力机制,通过嵌入位置信息到通道注意力,从而使移动网络获取更大区域的信息而避免引入大的开销,同时避免产生大量的计算开销。。为了避免2D全局池化引入位置信息损失,本文提出分解通道注意为两个并行的1D特征编码来高效地整合空间坐标信息到生成的attention maps中,能有效地整合空间坐标有效地将空间坐标信息整合到生成的注意图中。

具体而言,利用两个1D全局池化操作将沿垂直和水平方向的input features分别聚合为两个单独的direction-aware feature maps(位置感知)。 然后将具有嵌入的特定方向信息的这两个特征图分别编码为两个attention map,每个attention map都沿一个空间方向捕获输入特征图的远距离依存关系。 位置信息因此可以被保存在所生成的attention map中。 然后通过乘法将两个attention map都应用于input feature maps,以强调注意区域的表示。

考虑到其操作可以区分空间方向(即坐标)并生成coordinate-aware attention maps,因此论文将提出的注意力方法称为“coordinate attention”。

我们先来讲Coordinate Attention的优点:

1) 同时考虑了通道间关系和位置信息。它不仅捕获了跨通道的信息,还包含了direction-aware和position-sensitive(方向与位置敏感)的信息,这使得模型更准确地定位到并识别目标区域。

2) 这种方法灵活且轻量,很容易插入到现有的经典移动网络中,例如MobileNet_v2中的倒残差块和MobileNeXt中的沙漏块中去提升特征表示性能。

3) 对一个预训练的模型来说,这种coordinate attention可以给使用移动网络处理的down-stream任务带来明显性能提升,尤其是那些密集预测的任务,例如语义分割。

如下图中的C(coordinate attention)所示,分别对水平方向和垂直方向进行平均池化得到两个1D向量,在空间维度上Concat和1x1Conv来压缩通道,再是通过BN和Non-linear来编码垂直方向和水平方向的空间信息,接下来split,再各自通过1x1得到input feature maps一样的通道数,再归一化加权。

简单说来,Coordinate Attention是通过在水平方向和垂直方向上进行平均池化,再进行transform对空间信息编码,最后把空间信息通过在通道上加权的方式融合。

附上代码实现:

1 | import torch |

Conclusion

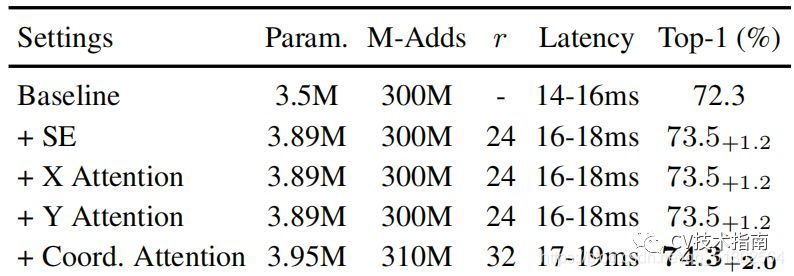

这种方式与SE,CBAM相比有明显提升。

注意力机制要加在哪里嘞?

如果对于本文提到的Coordinate Attention注意力机制,Paper Owner 是这样回答我的。

如果要加载别人的网络模型

因为不能改变已有的网络结构,所以注意力不能加在block里面,因为加进去网络结构发生了变化,所以不能用预训练参数。加在最后一层卷积和第一层卷积不改变网络,可以用预训练参数。(我对这段话有些小疑惑,下面是博主给我的回答)

两种初始化添加注意力后的网络的方法

1 | # 自己重写的网络 |

来自Mr DaYang(CSDN):

1 | pretrained_dict = torch.load(model_path)['state_dict'] # torch.load得到是字典,我们需要的是state_dict下的参数 |

如果打算从头炼

emmm 求路过大佬指教/doge

部分来自:

cv技术总结(知乎):https://zhuanlan.zhihu.com/p/363327384

CSDN:https://blog.csdn.net/qq_38410428/article/details/103694759